선형 회귀부터 딥러닝까지의 수학적 여정은 데이터를 해석하는 가장 단순한 방식에서부터 복잡한 패턴까지 점차 범위를 확장해가는 과정입니다. 이 여정의 수학적 핵심들은 다음과 같습니다.

· 선형 회귀(Linear Regression)

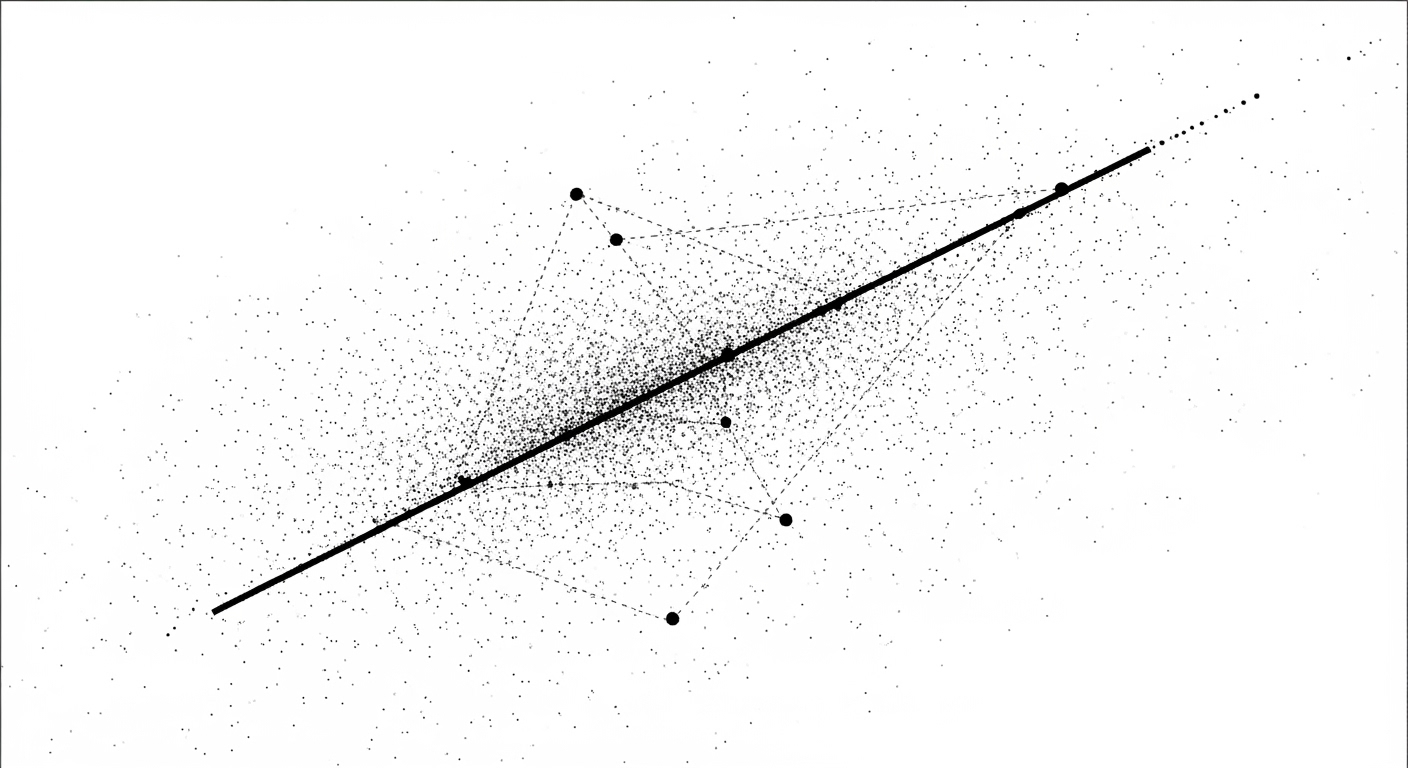

데이터의 특성과 목표 변수(예: 집값, 시험 점수 등) 사이의 직선적 관계를 찾는 것이 목적으로, 수학적으로는 $ y = a x + b $ 같은 1차 함수 형태로 모델링합니다.

"가장 잘 맞는 선"을 찾기 위해 최소제곱법(Least Squares Method)을 사용하여 오차(각 점과 직선의 거리 제곱의 합)를 최소화하는 값을 구합니다.

이 과정에서 평균, 분산, 행렬 연산, 미분(최적화) 등 기초 통계 수학이 요구됩니다.

· 다중 선형 회귀(Multiple Linear Regression)

여러 변수(설명 변수)를 써서 $ y = a_1 x_1 + a_2 x_2 + ... + b $ 식으로 확장합니다.

변수 수가 많을수록 행렬과 벡터 연산의 비중이 커지고, 역행렬 등 고등선형대수 개념을 이용하여 해를 구합니다.

· 딥러닝(Deep Learning)의 수학적 기반

딥러닝은 선형 회귀에서 한 단계 더 나아가, 비선형 함수, 여러 층의 신경망 구조를 사용합니다.

o 가중치(weight)와 편향(bias)의 반복적 조정

o 손실 함수(loss function): 평균제곱오차(MSE), 교차 엔트로피 등

o 경사하강법(Gradient Descent): 손실 함수를 미분해서 최적 파라미터를 찾고, 여기서 편미분, 행렬 미분, 연쇄법칙(Chain Rule) 등 고등 미적분이 쓰입니다.

o 비선형성: 활성화 함수(예: ReLU, sigmoid, tanh)로 데이터 표현 범위를 확대합니다.

· 실전 적용

o 실제 머신러닝/딥러닝에서는 통계적 가정, 과적합 방지, 정규화 등 수리통계적 요소와, 대규모 행렬연산의 효율성을 고려한 알고리즘(예: 백프롭, SGD)도 매우 중요합니다.

요약

· 선형 회귀: 평균, 분산, 미분, 행렬 등 기초 수학

· 다중 선형 회귀: 벡터, 행렬, 역행렬 등 선형대수

· 딥러닝: 미분, 최적화, 행렬 미분, 연쇄법칙, 비선형 함수 등 고수준 수학

이러한 수학적 원리들이 차례로 쌓이며, 단순한 데이터 관계 해석에서 인공신경망의 복잡한 패턴 학습까지 이어집니다.

'인공지능 수학' 카테고리의 다른 글

| 정보 이론과 AI 엔트로피정보 이론과 AI 엔트로피 (0) | 2025.08.12 |

|---|---|

| AI 모델 평가를 위한 통계적 기법 (0) | 2025.08.10 |

| 강화학습의 수학적 기초: MDP와 벨만 방정식 (0) | 2025.08.09 |

| 텐서란 무엇인가 : AI 수학의 기본 구성 요소 (0) | 2025.08.08 |

| 몬테카를로 방법 : AI와 확률적 접근 (0) | 2025.08.07 |